Notícias

Palestra sobre Defesa contra Ataques Adversariais em Modelos Lineares

Modelos de aprendizado de máquina podem ser vulneráveis a perturbações de entrada muito pequenas construídas de forma adversárial. Exemplos adversariais receberam muita atenção devido ao seu alto impacto no desempenho de modelos que, normalmente, produziriam resultados estado-da-arte. O treinamento adversárial é uma das abordagens mais eficazes para a defesa contra tais exemplos adversários e considera amostras perturbadas pelo adversário durante o treinamento para produzir modelos mais robustos.

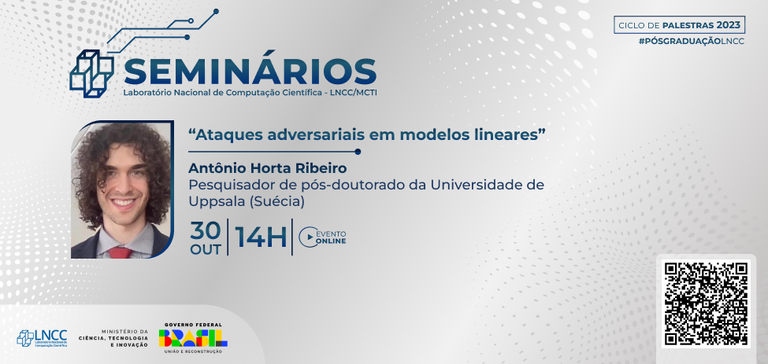

Nesse contexto, a próxima palestra oferecida pelo Programa de Pós-graduação do LNCC/MCTI, terá como tema: “Ataques adversariais em modelos lineares”. O evento acontece online na segunda-feira (30), às 14h e será ministrado por Antônio Horta Ribeiro, pesquisador de pós-doutorado da Universidade de Uppsala (Suécia).

Nessa apresentação será feita uma análise comparativa entre a solução de treinamento adversárial em regressão linear e outros métodos de regularização. Há uma forte razão para esse foco: modelos de regressão linear permitem uma análise detalhada do problema. Além disso, muitos fenômenos interessantes observados em modelos não lineares ainda estão presentes e podem ser melhor entendidos. Por exemplo, a configuração pode usada para estudar como a alta dimensionalidade pode ser uma fonte adicional de robustez ou fragilidade para modelos. O método também possui propriedades favoráveis que permitem seu uso como um método básico para a estimar de modelos lineares.

A transmissão será pelo aplicativo Zoom e ao vivo pelo canal do LNCC no YouTube. O evento é aberto ao público em geral.

- Para se inscrever, acesse: https://us02web.zoom.us/webinar/register/WN_Qfk1x0Z-RfmNjZh56W7CuQ