Histórico do LITCOMP

Até o final dos anos 1970, os computadores de grande porte (mainframes) eram utilizados no CBPF pelos grupos de pesquisas realizarem cálculos e simulações científicas em Física Nuclear e Raios Cósmicos (e.g. nos computadores da série IBM System/360). Eram grandes computadores, trancados em salas refrigeradas e operados apenas por especialistas. A computação científica do CBPF cresceu muito e deu início ao Laboratório Nacional de Computação Científica (LNCC), que se consolidou como instituição líder em Computação Científica e Modelagem Computacional no País. Entretanto, naquela época, a maior parte das instituições, incluído o CBPF, utilizava arquivos de metal, máquinas de escrever, papel carbono e memorandos de papel no seu dia-a-dia.

Devido a necessidade de controlar e realizar a automação da aquisição de dados dos experimentos científicos realizados nos diversos laboratórios de física do CBPF, a Coordenação de Atividades Técnicas (CAT, antiga denominação da COTEC) criou a Divisão de Informática (DIVI) que passou a desenvolver tecnologias em sistemas dedicados a automação e controle experimental, com base nos novos computadores pessoais, como por exemplo o TRS-80.

Sistema de Aquisição de Dados Dedicado - Macunaíma I e II

Em 1985, a DIVI desenvolveu o projeto de construção de um microcomputador de arquitetura aberta e totalmente dedicado à aquisição de dados, que foi denominado de Macunaíma. A primeira versão era bem simples e funcionou em racks de laboratórios com uma arquitetura ainda pouco escalável; entretanto a segunda geração – Macunaíma II, foi baseada no microprocessador Intel Z80, com 64 Kbytes de memória RAM, com interfaces de disco, vídeo, portas de comunicação em modo serial (RS232) e paralela. Naquela época, computador pessoal não era muito comum, e no Brasil somente apareceu no final da década de 80 com a chegada dos clones do computador pessoal IBM-PC no mercado. Os IBM-PCs eram uma arquitetura modular com peças facilmente encontradas no mercado, e uma grande variedade de fornecedores OEM*1 e de diversos países.

*1 - Original Equipment Manufacturer (OEM), ou em português, Fabricante do Equipamento Original,

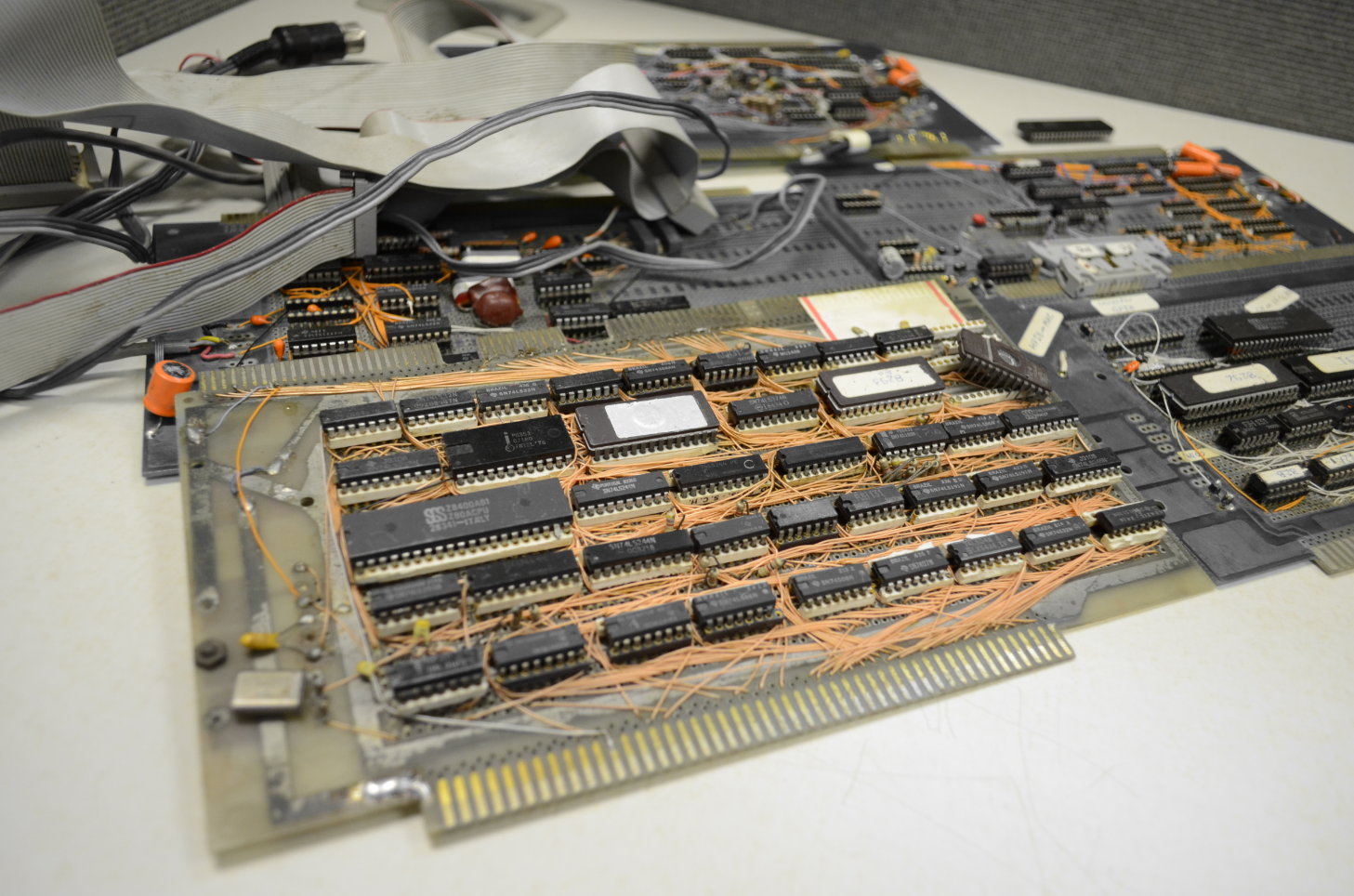

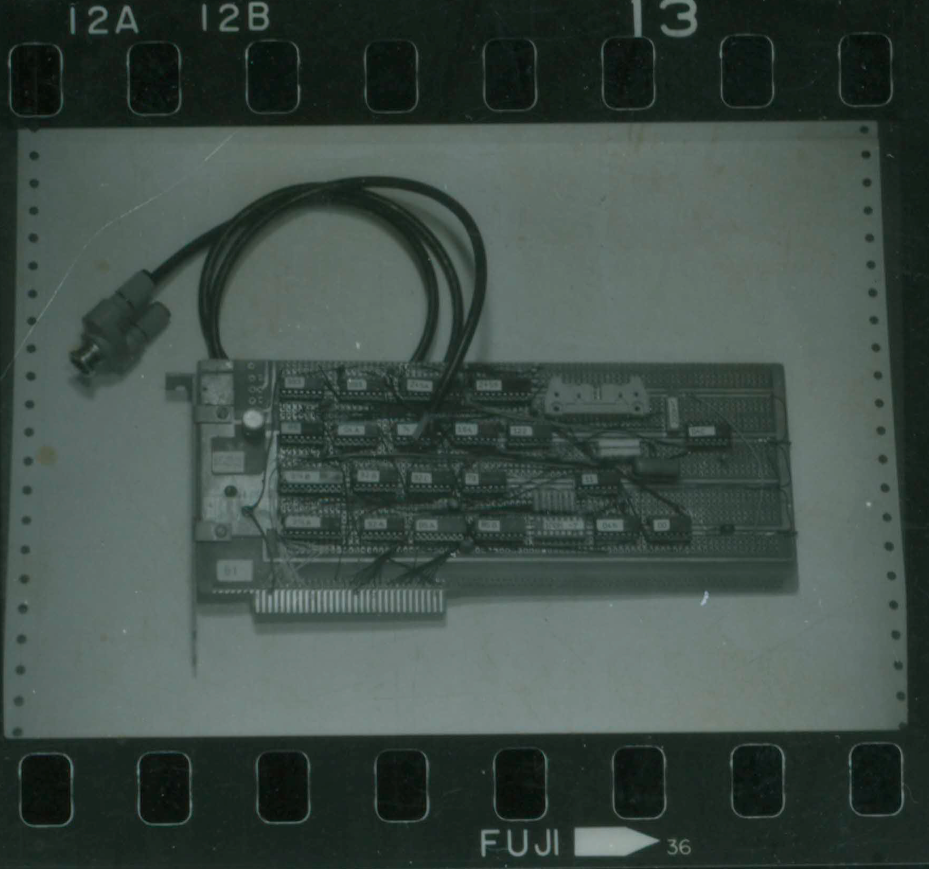

Figura - Computador Macunaíma II: a DIVI (Divisão de Informática do CBPF) projetou todos os circuitos eletrônicos (placa mãe, controladoras e interfaces de hardware), realizando a montagem e testes de integração – CPU, unidades de disco flexível, vídeo (texto e gráfico) e outros periféricos dedicados a aquisição e controle de experimentos. Em seguida foi projetada a estrutura física do computador, instalado monitores, discos, fontes para que esses viessem a ser utilizados nos laboratórios de física experimental do CBPF. O sistema operacional era o CDOS (Cromemco Disk Operating System), baseado no CP/M (Control Program for Microcomputers) da empresa Digital Research. O sistema foi recompilado com modificações para funcionar no projeto. O Macunaíma II foi instalado nos laboratórios de Resistividade Elétrica, Magnetometria (medidas de magnetização e susceptibilidade magnética), Ressonância Magnética Nuclear e Espectroscopia Paramagnética Eletrônica.

Figura: Placas do computador Macunaíma II que eram montadas usando fios wire wrap. Em primeiro plano a placa mãe que utilizava a CPU Z80A e tinha 64KBytes de memória RAM dinâmica.

Em 1987, a DIVI projetou, para o Computador Macunaíma II a interface GPIB destinada à comunicação com equipamentos de instrumentação científica, construída para todos os laboratórios do CBPF. A interface, definida no padrão IEEE 488, existe ainda hoje, e consiste em um barramento de propósito geral, com vistas à conexão de equipamentos científicos comerciais para controle por microcomputador. Além da interface, foi desenvolvida a biblioteca de software para ser utilizada nos sistemas de aquisição de dados dos laboratórios. Neste mesmo ano, na 39a Reunião Anual da Sociedade Brasileira para o Progresso da Ciência (SBPC), que se realizou em Brasília, o CBPF apresentou o projeto “Macunaíma II com interface GPIB”. Ele também foi apresentado, com o título de “Sistema de Aquisição de Dados Macunaíma II”, na primeira feira “Rio Tecnologia”, realizada em conjunto com a feira “Rio Negócios”, no Centro de Convenções do Riocentro (setembro/87) e na feira de tecnologia do Centro Federal de Educação Tecnológica Celso Suckow da Fonseca (CEFET-RJ).

Figura: A equipe da Divisão de Informática do CBPF apresentou o Sistema de Aquisição de Dados Macunaíma II com interface GPIB na feira de tecnologia do Centro Federal de Educação Tecnológica Celso Suckow da Fonseca (CEFET/RJ) em 1987.

Figura: Sistema de Aquisição de Dados Macunaíma II projetado para controlar o sistema de medida do Laboratório de Resistividade e Magnetometria em 1987.

Em 1989, a DIVI projetou um conversor analógico-digital de 12 bits para o Macunaíma II, publicado como Nota Técnica do CBPF, sob o título 'Conversor Analógico-Digital de 12 bits para Barramento Padrão S100' (CBPFNT002/89). No mesmo ano, foi desenvolvido um sistema de Programador de Pulsos utilizado nos laboratórios de Ressonância Magnética Nuclear, divulgado como Nota Técnica do CBPF, intitulada 'Programador de Pulso Aplicado à Ressonância Magnética Nuclear' (CBPFNT003/89). Além disso, foram produzidos conversores digital-analógico para os laboratórios de Magnetometria, Biofísica e Detectores Nucleares. Essas interfaces faziam do computador Macunaíma II um sistema adaptado para a aquisição de dados dos laboratórios do CBPF.

Após a instalação do hardware nos laboratórios do CBPF, vários programas foram criados para controlar os aparatos experimentais. Com o passar do tempo, os computadores do tipo IBM PC chegaram aos laboratórios do CBPF. Nessa época, foram desenvolvidas interfaces de comunicação para integrar o sistema de medição, baseado no Macunaíma II, aos novos computadores. A transferência do controle dos experimentos para os computadores comerciais foi apenas uma questão de tempo. Todas as interfaces projetadas para o Macunaíma II – GPIB, Conversores Analógico-Digital e Digital-Analógico, Programador de Pulso – foram adaptadas e aprimoradas para uso nos computadores do tipo PC.

Laboratório de Resistividade Elétrica

No Laboratório de Resistividade Elétrica, foi criado um ambiente integrado de medida de resistividade DC e AC. Inicialmente, em 1987, o sistema desenvolvido realizava a medida somente de resistividade DC para o Macunaíma II. Em 1989, foi projetado para ser controlado por um PC. Em ambos os casos, o sistema consistia em um Conversor Digital Analógico, em uma interface de inversão da corrente da amostra e em uma interface GPIB para a aquisição dos dados dos multímetros. Na parte de software, o sistema desenvolvido para o PC, incluía o controle da temperatura por PID (Controlador por meio de técnica proporcional, integral e derivativa). Todos os programas, desenvolvidos em Linguagem C, permitiram ao pesquisador usuário acompanhar a evolução da medida por meio de gráficos em tempo real. De forma a padronizar a interface gráfica, foi elaborada uma biblioteca de software, utilizada em todos os laboratórios, conhecida por DIVI.LIB. Os dados desse sistema eram preparados para serem tratados pelo programa de ajuste de curvas desenvolvido pelo Professor Nilton Alves Jr. Em 1994, foi concluído o Sistema de Aquisição de Dados para Medida de Resistividade AC, aproveitando as interfaces já construídas para a versão DC. O objetivo dele era a medida do valor da resistividade AC (ou DC) em função da temperatura. Tais ações, colocadas em prática no Laboratório de Resistividade, foram publicados na SBPC em 1994.

Laboratório de Magnetometria

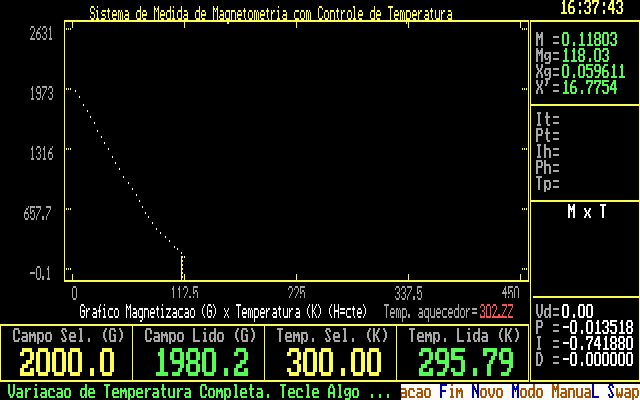

No Laboratório de Magnetometria, foi elaborado o sistema de aquisição de dados e automação da experiência de magnetização utilizando um magnetômetro de amostra vibrante. Nessa experiência, três técnicas diferentes de medidas foram elaboradas: magnetização x temperatura, magnetização x campo aplicado, e magnetização x tempo. Destas medidas são retiradas informações como a temperatura de transição de fase da amostra, momento efetivo, magnetização remanente, campo coercitivo, o comportamento da magnetização em função do tempo para alguns sistemas, magnetização espontânea etc. A leitura do valor do campo induzido era feita por um multímetro comercial com interface GPIB. Os programas de controles foram desenvolvidos em Linguagem C. A primeira versão foi elaborada para o Macunaíma II em 1989, e uma versão para o PC, com controle de temperatura por PID, terminada em 1993 (Figura abaixo). Esses trabalhos, no Laboratório de Magnetometria, foram publicados na SBPC e em Nota Técnica do CBPF, cujo título era “Sistema de Controle e Aquisição de Dados de um Laboratório de Magnetometria” (CBPF-NT-003/89).

Figura: Sistema de controle e aquisição de dados de um laboratório de magnetometria com controle de temperatura. Versão para PC (1993).

Laboratório de Ressonância Magnética Nuclear

No Laboratório de Ressonância Magnética Nuclear (RMN), foi desenvolvido a instrumentação necessária para o estudo por RMN pulsada de materiais magnéticos. Em 1988, a DIVI desenvolveu um sistema de medida baseado no Macunaíma II. Em 1990, tal sistema foi completamente projetado para o PC com a aquisição de conversores analógicos digitais rápidos LeCroy TR8818A) e um módulo CAMAC (IEEE583). De forma resumida, essas duas técnicas controlavam um gerador de freqüência com interface dedicada, um programador de pulso de N canais para determinar o envio do sinal de rádio freqüência (RF) à amostra. Uma varredura do espectro eletromagnético era programada pelo usuário para buscar por sinais de ressonância. O sinal de relaxamento, conhecido como “eco”, proveniente do espectrômetro Bruker, era digitalizado em dois canais em quadratura. Algumas médias desses sinais eram feitas a fim de reduzir o ruído. Durante todo o processo de medida, o espectro era mostrado na tela do computador sob a forma gráfica. Técnicas de eliminação do nível DC do sinal medido também foram efetuadas. Teses de mestrado e doutorado em Física foram feitas utilizando esses sistemas de medidas. Os trabalhos nesse laboratório, foram publicados na SBPC, em Nota Técnica do CBPF: “Programador de Pulso aplicado a RMN pulsada” (CBPFNT003/89). Serviram também como contribuição direta para a monografia de final de curso, em Engenharia de Telecomunicações, do Engenheiro Gustavo Fonseca Poppe de Figueiredo, na Universidade Federal Fluminense (UFFRJ), em 1990, intitulada: “Sistema de Aquisição de Dados para um Laboratório de Ressonância Magnética Nuclear Pulsada”. Esse sistema esteve em funcionamento no Laboratório de RMN até o ano de 1994 quando foi substituído pela versão em Windows.

Laboratório de Ressonância Paramagnética Eletrônica

No Laboratório de Ressonância Paramagnética Eletrônica, foi colocado em operação o sistema de aquisição de dados Macunaíma II no ano de 1988. Ligado por meio de uma interface ao espectrômetro comercial Varian E110, que foi modificado para aquisição digitalizada, fazia a varredura do campo, digitalizando o sinal de EPR por meio de um conversor analógico digital de 12 bits. O software de controle, desenvolvido em Linguagem C, acumulava os dados para reduzir o ruído, minimizando o erro experimental.

Laboratório de Detectores Nucleares

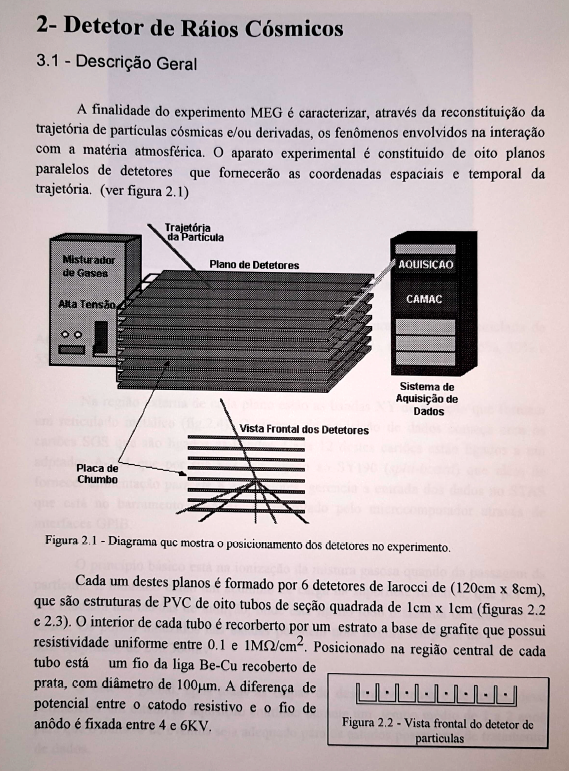

No Laboratório de Detectores Nucleares, foi colocado em prática o sistema de aquisição de dados para detectores de raios cósmicos em 1993. Esse trabalho foi realizado no CBPF em colaboração com o Engenheiro Luis Galhardo, do Instituto de Física da USP, e com o Instituto de Astronomia e Geofísica, da mesma universidade, para a experiência Microsul a ser realizada no Rio de Janeiro. O sistema consistia em módulos eletrônicos controlados por um microcomputador por meio de padrões CAMAC e GPIB. Esse trabalho foi projeto de graduação do Engenheiro Marcelo Portes de Albuquerque pelo CEFET/RJ, em 1993, denominado “Sistema de Aquisição de Dados para Detectores de Partículas”, sob a orientação dos Professores Trajano de Souza Vianna (CEFETRJ), Nilton Alves Júnior (CBPF) e Elly Silva (CBPF). Foi também apresentado no XV Encontro Nacional de Física de Partículas e Campos (XVENFPC), em Angra dos Reis, em outubro de 1993, com o título de “Sistema Automatizado para Teste, Calibração e Aquisição de Dados para Eletrônica FrontEnd em Tubos de IAROCCI”.

Figura: Projeto do Sistema de Aquisição de Dados para Detectores de Partículas IAROCCI para o experimento de detecção de raios cósmicos do CBPF (MEG - Muon, Elétron e Gama), desenvolvido em 1993.

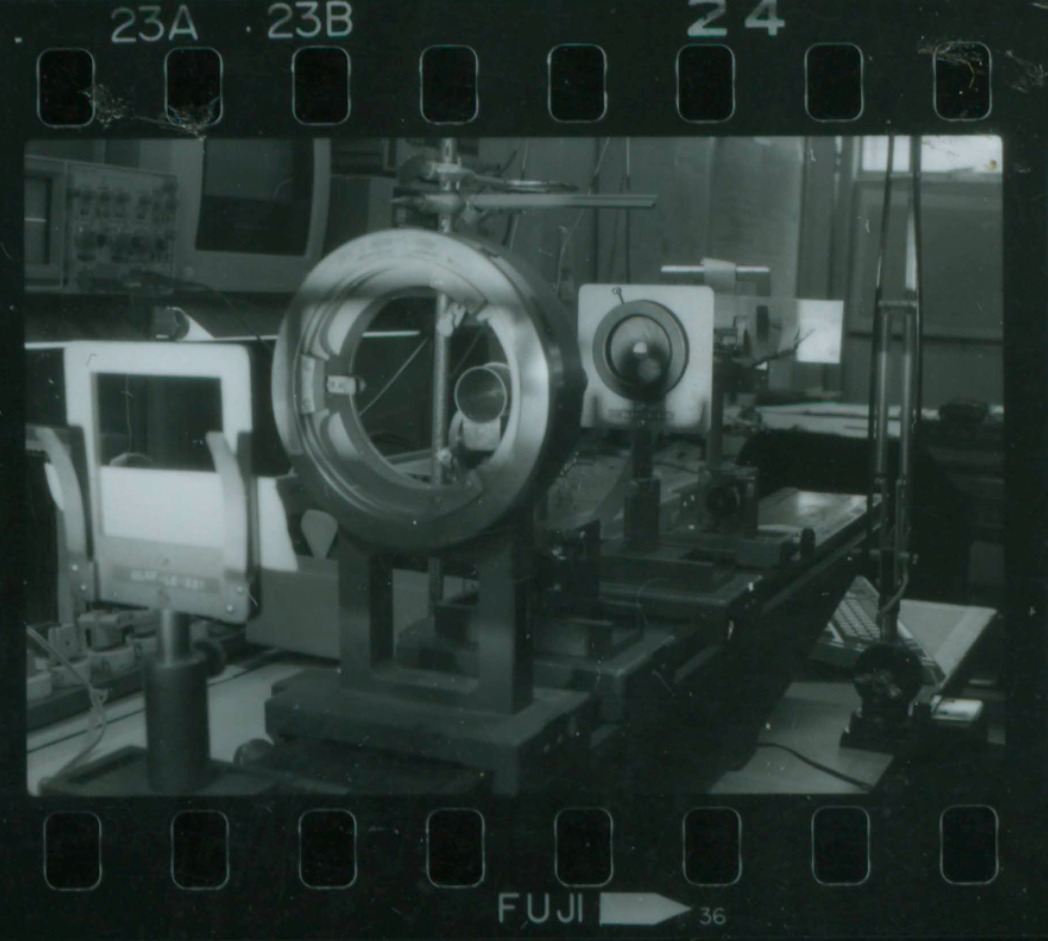

Figura: Laboratório de Detectores Nucleares no CBPF - Ano 1993.

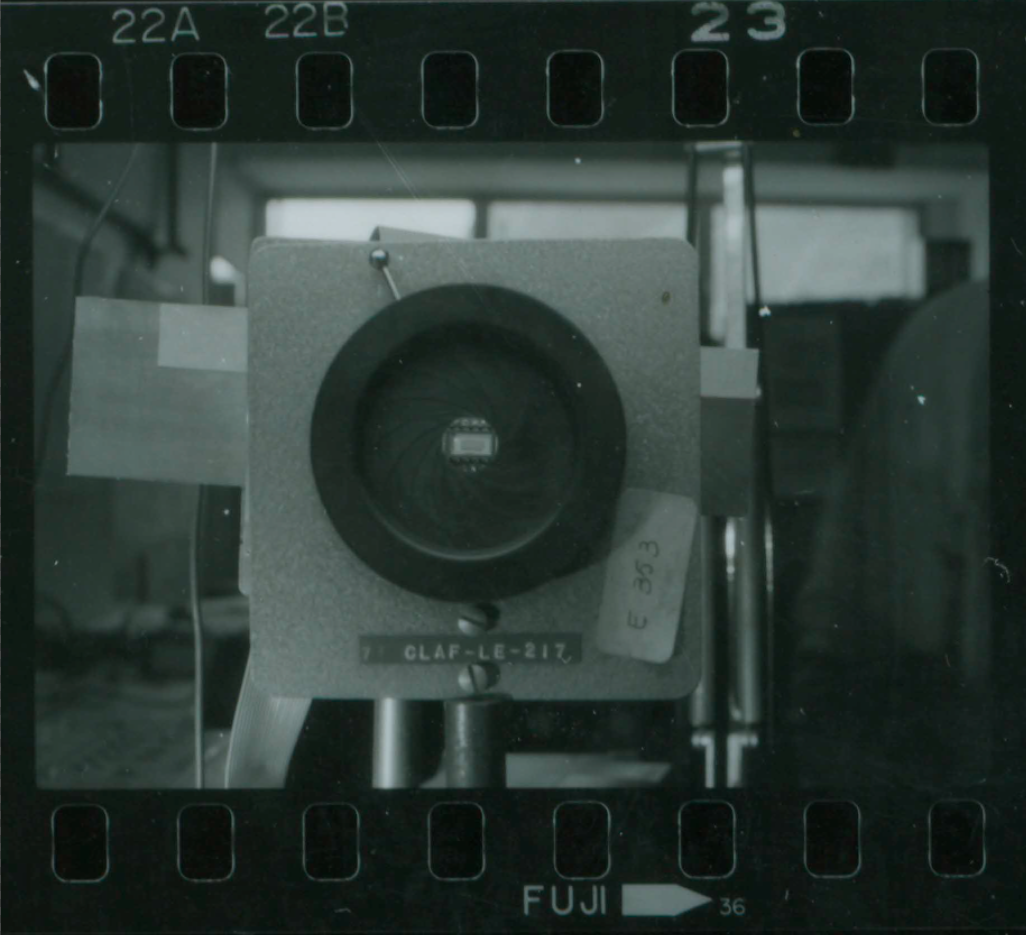

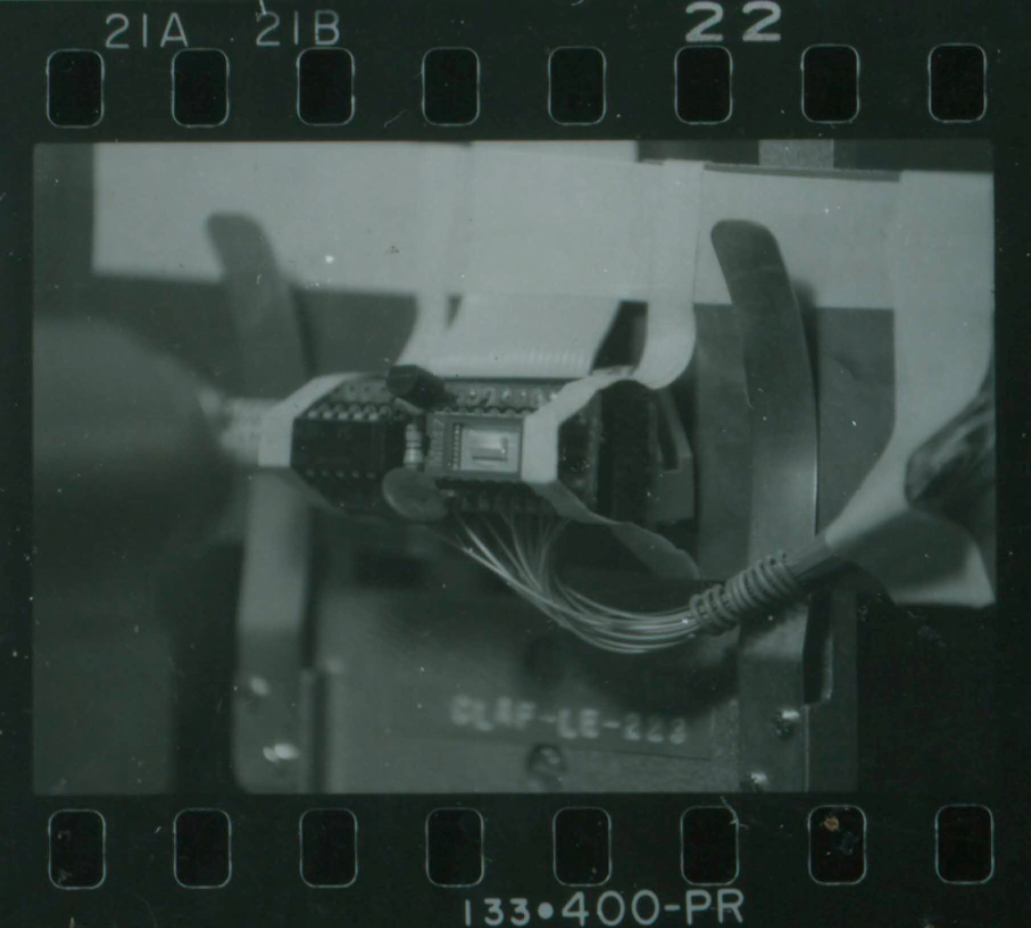

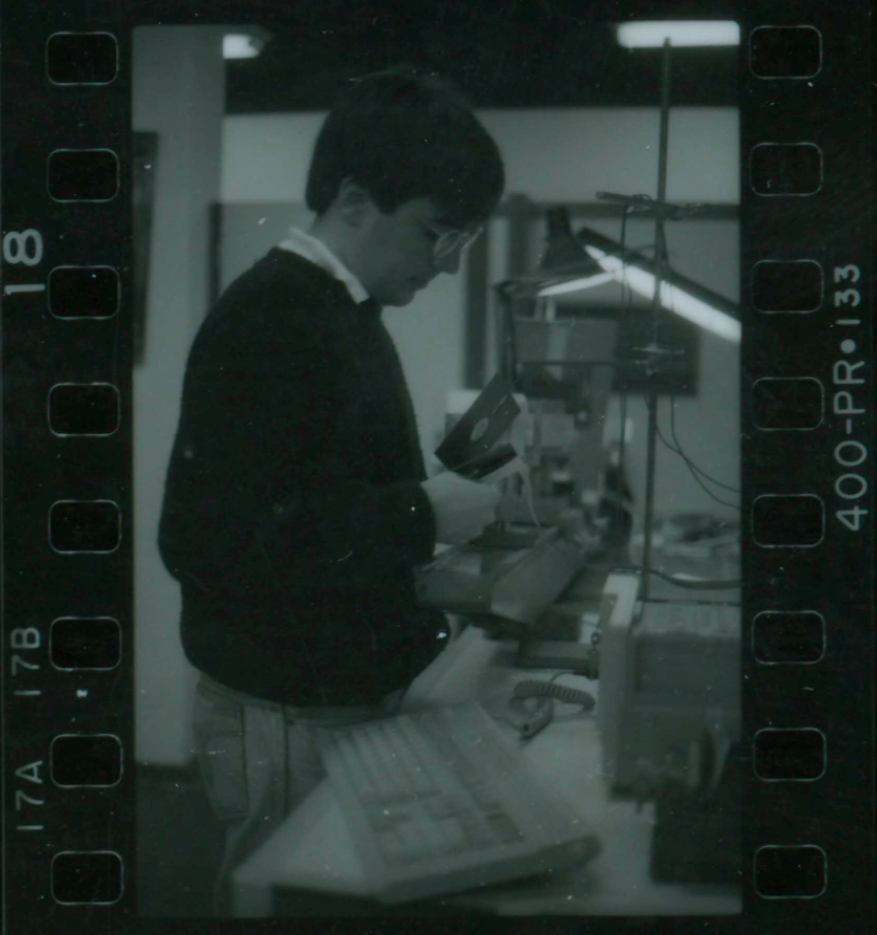

Durante todo esse tempo, a Divisão de Informática esteve interessada em análise de sinais e, por consequência, de imagens. Havia no CBPF uma demanda do Laboratório de Radiações e Geofísica Nuclear, liderado pelo Professor Alfredo Marques de Oliveira, para desenvolver sistemas de análises de imagens. Em 1989, a DIVI elaborou um sistema de aquisição de imagens binárias. O sistema constava de um elemento sensor de 64K células, uma interface para computadores compatíveis com o IBMPC e uma software desenvolvido nas linguagens C e Assembly que fazia a aquisição, armazenamento e mostrava no vídeo uma imagem de alto contraste. Foi publicado como projeto de graduação, do Engenheiro Márcio Portes de Albuquerque, em Engenharia de Sistemas de Computação, pela Universidade do Estado do Rio de Janeiro, em 1991, intitulado “Sistema de Aquisição de Imagens”.

Figura: Sistema de Aquisição de Imagens sendo projetado na Divisão de Informática do CBPF.

Laboratório de Microorganismo Magnetotácticos

Em 1994, no Laboratório de Microorganismo Magnetotácticos, do CBPF, foi desenvolvido um sistema de medida para fornecer a trajetória e a velocidade do movimento, além do momento magnético de microorganismos sob a presença de campos magnéticos conhecidos. Para tal projeto, foram utilizadas interfaces de processamento de sinais e imagens comerciais em que elaboramos um software para o processamento e reconstrução dessa trajetória em Linguagem C para Windows. O sistema permitia a inversão do campo magnético controlado pelo computador. Esse trabalho foi o projeto de graduação em Engenharia Eletrônica, de A. P. Garcia Rocha e S. Mara, para o CEFET-RJ, cujo nome era “Sistema de Aquisição e Processamento de Imagens”, sob a orientação de Marcelo Portes de Albuquerque e da Professora Darci Motta de Souza Esquivel, sendo publicado na XVIII Encontro Nacional de Física da Matéria Condensada.

Laboratório de Física Experimental em Altas Energias

Para o Laboratório de Física Experimental em Altas Energias (LAFEX), foi desenvolvido o software demonstrativo do computador paralelo do CBPF. Foi apresentado na feira de informática SUCESU 90, realizado no Riocentro em 1990 (Figura abaixo), no III ICFA School on Instrumentation in Elementary Particle Physics, realizada no CBPF.

FIGURA: Programa demonstrativo da segunda versão do sistema multiprocessador ACP (Advanced Computer Program), o computador paralelo do CBPF apresentado na feira de informática SUCESU90.

Projetos e Desenvolvimentos Tecnológicos Antigos

- PROCESSAMENTO DE SINAIS E INSTRUMENTAÇÃO CIENTÍFICA:

O LITCOMP tem desenvolveu instrumentos e tecnologias de medidas em microscopia óptica com arranjo móvel de polarização e a implementação de um arranjo de super-resolução. Nesse sentido, o LITCOMP realizou um estudo sobre métodos computacionais de geração de processos 1/f via processamento digital de sinais. Neste trabalho foi apresentado um estudo aprofundado sobre técnicas lineares de geração de ruídos com características 1/fα. São revistos conceitos de Processamento Digital de Sinais, bem como de Processos Estocásticos, de forma a dar substrato aos desenvolvimentos computacionais. Metodologias baseadas em filtros de resposta finita e infinita – FIR e IIR, respectivamente – são desenvolvidas e comparadas. É mostrado que ambas estratégias permitem geração de ruídos 1/f com robustez e confiabilidade, permitindo inclusive que se administre os intervalos de frequências em que o comportamento desejado se manifesta.

- AMPLIFICADOR LOCK-IN:

Desenvolvimento de uma ferramenta amplamente utilizada em laboratórios científicos, o amplificador lock-in. Esta ferramenta é baseada em processadores de sinal digital (DSP). Ele foi projetado para operar em altas frequências (2 MHz) e pode ser aplicado no estudo de materiais avançados, como aqueles com potencial tecnológico, como supercondutores de alta temperatura crítica, materiais magnéticos, manganitos etc. O Lock-in foi o resultado de um Tese de mestrado no Programa de Instrumentação Científica do CBPF em 2008. Link para tese do Maurício Bochner.

http://www.cbpf.br/~rastuto/lockin/index.html

- IDENTIFICAÇÃO DE ARCOS GRAVITACIONAIS:

O grupo trabalhou no desenvolvimento de técnicas de análise de imagens para aplicações em nanotecnologia e magnetismo, reconstrução otimizada de sinais em experimentos físicos, técnicas baseadas em novas teorias da física estatística, reconhecimento de padrões usando redes neurais artificiais, transformações espaciais e métodos estatísticos . Um exemplo de aplicação de processamento de imagens em física é a identificação de arcos gravitacionais em imagens astronômicas que estão sendo realizadas no Projeto DES-Brasil (Dark Energy Survey). Outro exemplo é o desenvolvimento de técnicas de processamento de imagens que permitem a análise de processos microscópicos que ocorrem na superfície de um material durante o processo de nanoestruturação. Como resultado, foi necessária uma patente brasileira para esta última. Link Patente Arcos Gravitacionais.

- PROJETO NEXTCOMP E COMPUTAÇÃO DISTRIBUÍDA:

O grupo também trabalha no Projeto NextComp. Neste projeto, desenvolvemos simulações de dinâmica molecular de sistemas de interações de longo alcance que podem ser escaláveis para milhares de processadores em sistemas de computador de alto desempenho. O novo algoritmo foi desenvolvido em linguagem orientada a objetos, CHARM ++. Em 2007, foi realizada uma simulação com 1000 processadores no cluster de computação NCSA (National Center for Supercomputing Applications - EUA). Atualmente, em parceria com a Universidade Estadual do Estado do Rio de Janeiro - UERJ, novos códigos de computador foram desenvolvidos no CHARM ++, para simular uma tomografia de raio-X usando programação paralela em sistemas de computação de alto desempenho. Os cálculos de reconstrução das imagens foram realizados no cluster do Centro de Supercomputação da Universidade Federal do Rio Grande do Sul (CESUP / UFRGS). Link para PPT/Explicando o Projeto.; NextComp Project - Molecular Dynamics on a Computational Grid Environment

- REDES COMPLEXAS:

Esta área está dividida em dois eixos: P&D e serviços especializados. Os primeiros têm dois interesses principais; o primeiro é a caracterização das estruturas de redes, como a topologia da Internet, seu desenvolvimento e relacionamentos, redes complexas e aplicações de mecânica estatística não extensiva. O segundo diz respeito à caracterização dos mecanismos relacionados ao impacto das citações científicas. Link para Tese do Nilton Alves.

- CÁLCULO DA DIMENSÃO FRACTAL - MÉTODO DE BOXCOUNTING -

Fractais são formas complexas que não podem ser medidas apenas por dimensão topológica . A dimensão fractal surge então como uma alternativa de medição já que pode assumir valores fracionários, obtendo assim o grau de complexidade de uma forma. Pode-se afirmar que a dimensão fractal de um conjunto é um valor que diz o quão densamente um conjunto ocupa o espaço métrico em que ele existe. Dentre os vários cálculos de dimensão fractal existentes, o Box-counting ou box dimension é um dos mais utilizados. Sua grande popularidade se deve a sua facilidade de uso em cálculos matemáticos e em estimativas experimentais. O algoritmo para o cálculo dessa dimensão considera uma figura qualquer coberta por um conjunto de quadrados, e calcula o número de quadrados necessários para cobrir toda a figura que é representado por N(s), sendo s a escala, ou seja, número de vezes que o lado da imagem será dividido. Essa divisão pode ser observada nas figuras 1.a e 1.b. E a dimensão fractal será o coeficiente angular do diagrama log(N(s))/log(1/s).

http://www.cbpf.br/cat/pdsi/boxcounting/index.html

- CÁLCULO DA RUGOSIDADE - MÉTODO DE BOXCOUNTING

Materiais nanoestruturados apresentam propriedades distintas comparadas com materiais em volume e tem sido de grande interesse tecnológico devido a suas possíveis aplicações, como, por exemplo:

- Síntese de materiais nanoestruturados formando poros em óxido para moldes de materiais magnéticos;

- Formação de superfícies seletivas para painéis de coletores solares para conversão de energia fototérmica.

A utilização da Microscopia de Força Atômica (AFM) como técnica de aquisição de imagens para este tipo de material pode fornecer informações úteis a fim de analisá-lo com detalhes. Técnicas de processamento de imagens podem permitir analisar os processos microscópicos que acontecem na superfície do material durante o processo de nanoestruturação.

http://www.cbpf.br/cat/pdsi/rugosidade/index.html

- CURSO DE PROCESSAMENTO DE SINAIS E IMAGENS - IV ESCOLA DO CBPF:

Em muitos laboratórios de física experimental, é muito comum que os resultados das medidas, representando algum comportamento físico, sejam sob a forma de imagens. Nestes casos, devemos utilizar técnicas de análise de imagens a fim de restaurar, segmentar, reconhecer ou interpretar esses resultados. A área de processamento de imagens auxilia os pesquisadores na análise de suas medidas, como, por exemplo, a contagem de grãos, a evolução de domínios magnéticos, o cálculo de densidade magnéticas, o reconhecimento de padrões etc. O processamento digital de imagens é, certamente, uma área em expansão nos laboratórios de física experimental.

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

- PROCESSAMENTO DIGITAL DE IMAGENS:

As imagens são produzidas por uma variedade de dispositivos físicos, tais como câmeras e vídeo câmeras, equipamentos de radiografia, microscópios eletrônicos, magnéticos e de força atômica, radares, equipamento de ultra-som, entre vários outros. A produção e utilização de imagens podem ter diversos objetivos, que vão do puro entretenimento até aplicações militares, médicas ou tecnológicas. O objetivo da análise de imagens, seja por um observador humano ou por uma máquina, eh extrair informações úteis e relevantes para cada aplicação desejada. Em geral, a imagem pura, recém adquirida pelo dispositivo de captura, necessita de transformações e realces que a torne mais adequada para que se possa extrair o conteúdo de informação desejada com maior eficiência. O Processamento Digital de Imagens (PDI) é uma área da eletrˆonica/teoria de sinais em que imagens são convertidas em matrizes de números inteiros, sendo que cada elemento desta matriz é composta por um elemento fundamental: o pixel (uma abreviação de picture element). A partir desta matriz de pixels que representa a imagem, diversos tipos de processamento digital podem ser implementados por algoritmos computacionais. A aplicação destes algoritmos realizam as transformações necessárias para que se possa, por exemplo, obter uma imagem com os realces pretendidos ou extrair atributos ou informações pertinentes. O PDI será considerado neste trabalho como a união das áreas de processamento de imagem e visão computacional.

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

- FUNDAMENTOS DA TEORIA DA INFORMAÇÃO:

A Teoria da Informação é uma ramificação da teoria de probabilidades introduzida por Claude Shannon com a publicação do artigo “The Mathematical Theory of Communication” em 1948, apresentando um novo modelo matemático para o estudo de sistemas de comunicação. Os principais objetivos de Shannon eram descobrir as leis que regulam os sistemas usados para comunicar e manipular a informação e definir medidas quantitativas para a informação e para a capacidade de determinados sistemas transmitirem, armazenarem e processarem a informação. Uma das inovações mais importantes do modelo introduzido por Shannon, foi considerar os componentes de um sistema de comunicação (fontes de informação, canais de comunicação) como elementos probabilísticos. Alguns dos problemas abordados por Shannon estão relacionados com a descoberta de melhores métodos para utilizar os sistemas de comunicação existentes e as melhores formas de separar a informação desejada (sinal) da informação desprezível(ruído). Um outro tema abordado é a definição de limites superiores para as possibilidades do meio de transporte de informação, também chamado um canal de comunicação. Shannon propôs uma forma de medição quantitativa da informação fornecida por um evento probabilístico, baseada na tradicional expressão de entropia de Boltzmann (1896) presente na termodinâmica e física estatística. Foi Shannon quem primeiro relacionou entropia e informação. Em seu modelo de comunicação (fonte-canal-receptor)[1], a quantidade de informação transmitida em uma mensagem é função de previsibilidade da mensagem. A noção de entropia está ligada ao grau de desorganização existente na fonte de informação. Quanto maior a desordem, maior o potencial de informação desta fonte. Uma fonte que responda com uma única e mesma mensagem a toda e qualquer pergunta não transmite informação, já que não há redução de incerteza.

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

- INTRODUÇÃO AO PROCESSAMENTO DIGITAL DE IMAGENS:

Neste artigo procuramos dar uma visão da área de processamento digital de imagens e suas aplicações. Abordamos conceitos importantes sobre a representação espacial de um pixel, a medida de distâncias, a segmentação de uma imagem e o reconhecimento de formas. Utilizamos situações reais para exemplificarmos as técnicas apresentadas. É nosso objetivo abordar de forma introdutória e simplificada o tema. Ao final discutimos sobre os diversos pacotes existentes para processamento digital de imagens e apresentamos uma bibliografia útil para se aprofundar em processamento de imagens e visão por computador.

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

- CONCEITOS BÁSICOS VISÃO POR COMPUTADOR:

O objetivo desta Home-Page é descrever de forma básica os principais conceitos em visão por computador, esclarecendo as diferenças entre esta disciplina e as disciplinas irmãs (Computação Gráfica, Processamento de Imagens, etc). Abaixo apresentamos as transparências usadas na parte introdutória do curso de Processamento Digital de Imagens e suas Aplicações do Mestrado em Instrumentação Científica do CBPF. Sempre que possível procuramos detalhar e exemplificar os pontos principais para facilitar a compreensão do tema. Ao final listamos as principais bibliografias sobre o assunto. Maiores informações podem ser encontradas na minha própria Home-Page (http://www.cbpf.br/~mpa) ou no Projeto Análise de Imagem aplicada a Física. Para quaisquer dúvidas sobre o assunto, informações sobre estágios ou bolsas de Desenvolvimento Tecnológico, ou sobre Parcerias e Consultorias na área de Imagens, escreva para : mpa@cbpf.br

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

http://www.cbpf.br/cat/pdsi/downloads/Ciencia%20Hoje%20Vis%C3%A3o%20Eletr%C3%B4nica%20Junho%20de%202005.pdf

- EXEMPLO DE APROXIMAÇÃO DE UM HISTOGRAMA POR UMA FUNÇÃO DE DISTRIBUIÇÃO GAUSSIANA:

Mostrar através de um exemplo simples o procedimento para o cálculo da função de densidade de probabilidade Normal (Função de Gauss) através do histograma de um ruído branco.

http://www.cbpf.br/cat/pdsi/top_pesquisa.htm

- POSTER PROCESSAMENTO DE SINAIS:

http://www.cbpf.br/cat/pdsi/top_poster.htm

http://www.cbpf.br/cat/pdsi/images/PosterPDI.jpg

- APLICAÇÃO DA TÉCNICA DE MOMENTOS INVARIANTES NO RECONHECIMENTO DE PADRÕES EM IMAGENS DIGITAIS:

Este trabalho aborda a técnica de extração de características em “objetos” presentes em uma imagem digital. Os objetos, parâmetros de entrada do sistema de reconhecimento, são descritos por agrupamentos de pixels previamente separados do fundo da imagem e serão analisados estatisticamente. Todo objeto dentro de um sistema de reconhecimento é descrito por suas características ou atributos. Estas características são representadas em um espaço N dimensional, onde N é o número de características. Cada objeto forma assim, um vetor dentro deste espaço de características, chamado de vetor de características.

http://www.cbpf.br/~chacon/mhu/#introducao

- PROCESSADOR DIGITAL DE SINAIS - DSP:

Nas últimas duas décadas ocorreu uma grande evolução na área de processamento de sinais. O que antes era feito de forma analógica, com pouco controle sobre o meio físico envolvido agora pode ser feito de forma digital, controlada, muito mais precisa e rápida. Esta evolução deve-se a criação do DSP. O DSP, ou Processador Digital de Sinais (Digital Signal Processor), sao ferramentas muito versáteis, de fácil integração ao usuário, permitindo este realizar qualquer tipo de trabalho ou projeto desejado.

http://www.cbpf.br/~rastuto/

- PDI - TOMOGRAFIA:

O trabalho tem por objetivo separar regiões e atributos de interesse de imagens de tomografia, utilizando técnicas de processamento digital de imagens. Como ferramenta foi usado o MATLAB e o toolbox de processamento de imagens, e as imagens são de um boneco antropomórfico usado para calibração de aparelhos de raio-X.

http://www.cbpf.br/cat/pdsi/tomo/index.html

- PROCESSAMENTO DE SINAIS E IMAGENS NA SEMANA NACIONAL DE CIÊNCIA E TECNOLOGIA / 18 - 24 DE OUTUBRO DE 2004:

O LPDSI participou da Semana Nacional de Ciência e Tecnologia apresentando algumas atividades de processamento de sinais e imagens utilizadas no CBPF. Nosso objetivo foi apresentar técnicas básicas de processamento de imagens e visão por computador. A interpretação de imagens por computador é uma importante ferramenta para diversas áreas tecnológicas. A variedade de aplicações do "Processamento de Imagens" (PI) está associada à análise da informação presente na imagem. A apresentação consistiu na demonstração das técnicas de PI que são desenvolvidas no CBPF, aplicadas tanto em laboratórios de pesquisa quanto em setores industriais.

http://www.cbpf.br/cat/pdsi/snct2004/index.html

- ANÁLISE DE IMAGENS E FÍSICA

Desenvolver no CBPF um ambiente de Processamento de Imagens, Computação Gráfica e Visão por Computador e construir desta forma processos computacionais e experimentais dedicados à imagens provenientes de fenômenos físicos.

http://www.cbpf.br/cat/pdsi/iap/index.html

- LATTICE PARAMETER ANALYSER - LPA

The Lattice Parameter Analyser (LPA) is a Matlab program developed with the objective of extracting automatically values of the characteristics of atomic lattice of High Resolution Electron Microscopy (HREM) from Transmission Electron Microscope (TEM).

http://www.cbpf.br/cat/pdsi/lpa/index.html

- CÁLCULO DE DOMÍNIOS MAGNÉTICOS EM FILMES FINOS ATRAVÉS DE PROCESSAMENTO DE IMAGENS

Os efeitos ópticos que exibem a influência de um campo magnético sobre a propagação da luz num material colocado sob a ação do campo, são conhecidos como efeitos magneto-ópticos. De uma maneira geral, os efeitos magneto-ópticos ocorrem devido às interações entre o feixe de fótons e os elétrons do material no qual ele se propaga. Podemos distinguir três domínios principais de utilização desses efeitos. O estudo do magnetismo macroscópico, no qual se insere o nosso trabalho, é a principal área de atuação da magneto-óptica.

http://www.cbpf.br/cat/pdsi/DominiosMag/index.html

- PROCESSAMENTO DIGITAL DE SINAIS E IMAGENS:

Em muitos laboratórios de física experimental, é muito comum que os resultados das medidas, representando algum comportamento físico, sejam sob a forma de imagens. Nestes casos, devemos utilizar técnicas de análise de imagens a fim de restaurar, segmentar, reconhecer ou interpretar esses resultados. A área de processamento de imagens auxilia os pesquisadores na análise de suas medidas, como, por exemplo, a contagem de grãos, a evolução de domínios magnéticos, o cálculo de densidade magnéticas, o reconhecimento de padrões etc. O processamento digital de imagens é, certamente, uma área em expansão nos laboratórios de física experimental.

http://www.cbpf.br/cat/pdsi/curso_7g.htm

- TÉCNICAS DE ENTROPIA EM PROCESSAMENTO DE IMAGENS:

Este estudo concerne a utilização de métodos entrópicos aplicados como técnicas de processamento digital de imagens. O conceito de entropia, e mais recentemente o de entropia generalizada, foi aplicado como base para a segmentação de imagens e reconhecimento de padrões. A importância da análise quantitativa de imagens em diversas áreas da ciência tem motivado o desenvolvimento contínuo de novas técnicas de processamento de sinais. Este trabalho propõe novos métodos de segmentação de imagens revendo e ampliando as técnicas clássicas e também uma nova técnica de reconhecimento de padrões baseada no cálculo da entropia das formas presentes na imagem. Uma análise detalhada dos métodos entrópicos, com resultados em casos simulados e sistemas reais é apresentada e mostra que as técnicas de segmentação propostas são mais robustas e eficientes. Em termos do reconhecimento de padrões, testes mostram que a introdução da entropia relativa generalizada permite uma melhora na eficiência do classificador, através de um ajuste fino do parâmetro de não extensividade q.

http://cbpfindex.cbpf.br/index.php?module=main&moduleFile=pubDetails&pubId=3&typeId=10

- SIMULAÇÃO DE TOMOGRAFIA COMPUTADORIZADA DE RAIOS X:

Programa para simulação de tomografia computadorizada de Raios X utilizando programação paralela em sistemas de processamento de alto desempenho. O programa desenvolvido implementa modelos físicos da interação da radiação com a matéria, como, por exemplo, o espalhamento coerente (Rayleigh) e de transmissão de raios X.

http://cbpfindex.cbpf.br/index.php?module=main&moduleFile=pubDetails&pubId=2208&typeId=8

- DESENVOLVIMENTO DE UM SIMULADOR PARA ESPECTROMETRIA POR FLUORESCÊNCIA DE RAIOS X USANDO COMPUTAÇÃO DISTRIBUÍDA:

A Física das Radiações e um ramo da Física que está presente em diversas áreas de estudo e se relaciona ao conceito de espectrometria. Dentre as inúmeras técnicas espectrométricas existentes, destaca-se a espectrometria por fluorescência de raios X. Esta também possui uma gama de variações da qual pode-se dar ênfase a um determinado subconjunto de técnicas.

PDF no Email Marcelo - Tese Marcio Henrique dos Santos

Veja aqui os Termos de Uso Institucionais e Conformidade Legal

LOCALIZAÇÃO

LITCOMP - LABORATÓRIO DE INSTRUMENTAÇÃO E TECNOLOGIA DE COMPUTAÇÃO

COTEC - Coordenação de Desenvolvimento Tecnológico

3o Andar/ Ala C Edifício César Lattes

CBPF - Centro Brasileiro de Pesquisas Físicas

Rua Dr. Xavier Sigaud, 150

URCA Rio de Janeiro/RJ

CEP: 22.290180

Rodapé

Links Rápidos | Redes Sociais | Créditos